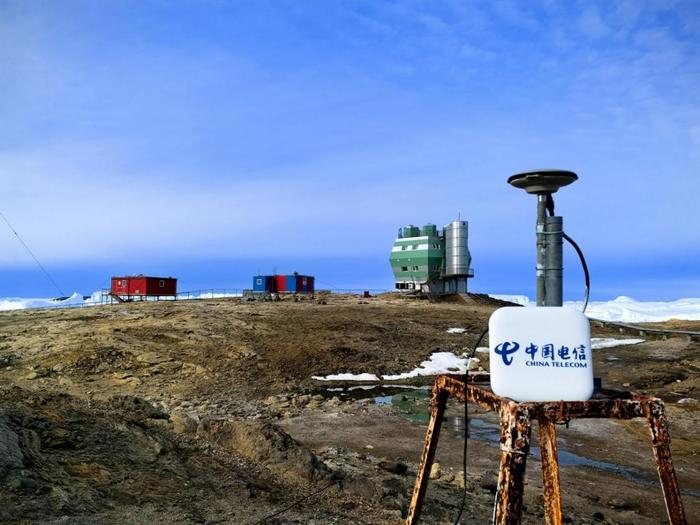

1 月 25 日消息,从中国电信人工智能研究院获悉,其“复杂推理大模型”TeleAI-t1-preview 现已正式发布,即将上线天翼 AI 开放平台。TeleAI-t1-preview 使用了强化学习训练方法,通过引入探索、反思等思考范式,大幅提升模型在逻辑推理、数学推导等复杂问题的准确性。

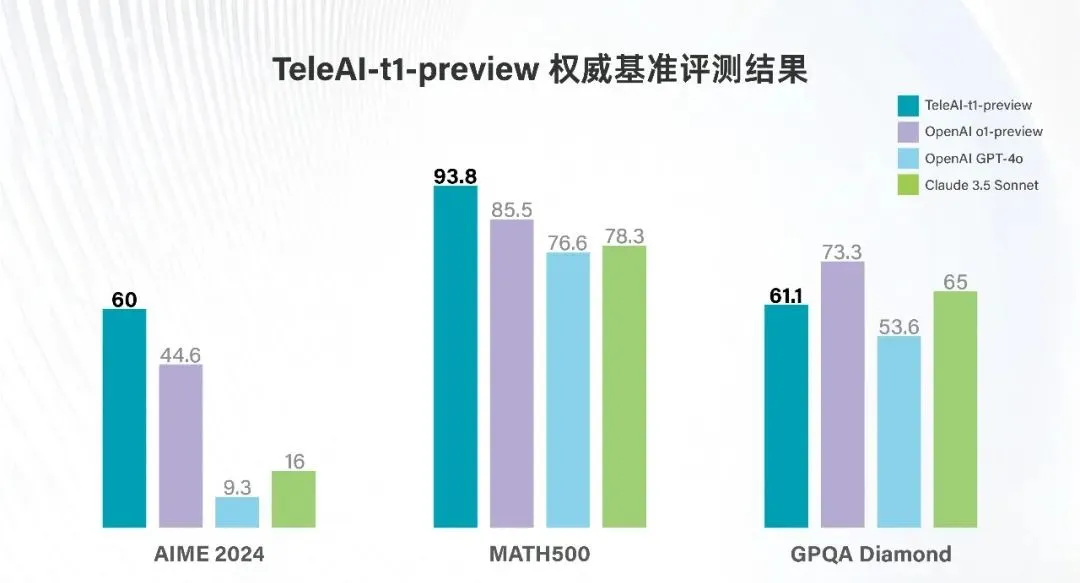

官方表示,在美国数学竞赛 AIME 2024 、MATH500 两项数学基准评测中,TeleAI-t1-preview 分别以 60 和 93.8 分的成绩,大幅超越 OpenAI o1-preview、GPT-4o 等标杆模型。在研究生级别问答测试 GPQA Diamond 中,TeleAI-t1-preview 得分超过 GPT-4o,并比肩 Claude 3.5 Sonnet 的性能水准。

评测显示,将《九章算术》中的一道题目给到 TeleAI-t1-preview 后,其能够先针对文言文进行理解和简化,再转换成现代汉语,随之给出数学推导和答案。

据介绍,在此过程中,TeleAI-t1-preview 可将形象思维与抽象思维结合,对所涉及的场景进行具象化思考,辅助理解题目。不仅如此,其还能够严谨地进行古今单位换算。

TeleAI 引入了创新的训练策略,从而保障思考推理过程准确有效。

数据准备阶段:收集、构建了一个以数学为核心、多学科为补充的高质量推理数据集,确保模型能够适应不同类型的推理任2024澳正版资料免费大全189期务。

Judge Model(评估模型):训练了一个 Judge Model 专门用于分析和评估模型长思考链路的正确性,为模型的反思和错误修正提供指导。

SFT(监督微调)阶段:用 MCTS(蒙特卡洛树搜索)构造高质量长推理数据,结合每个步骤的准确率和解决方案长度来选择最优的完整路径,在保证推理答案准确性的同时有效拉长思考链路以获得更细粒度的推理过程。同时使用 Judge Model 对推理过程中正确率较低的路径进行分析,引导模型对错误的推理步骤进行反思和修正,从而构造出高质量的思维链数据进行 SFT 训练。

强化学习阶段:额外构造了 Rule-based Reward Model(基于规则的奖励模型),以提供足够准确的奖励信号,通过在线强化学习算法进一步提升模型的逻辑推理能力。

发表评论