12 月 20 日消息,Meta 公司携手华盛顿大学和卡内基梅隆大学,组建科研团队,合作开发了 ExploreToM 框架,旨在更有效地评估和训练大语言模型(LLM)的心智理论(Theory of Mind,ToM)能力。

心智理论

心智理论(Theory of Mind,ToM)是人类社会智能的基础之一,能让我们能够理解他人的想法、意图和信念。这种认知能力对于有效的沟通和协作至关重要,是复杂社交互动的支柱。

让 AI 也具备 ToM 能力,对于创建能与人类无缝互动的智能体至关重要,只是当前大型语言模型(LLM)在 ToM 方面仍面临巨大挑战。

现有的基准通常缺乏复杂性和多样性,导致高估模型能力。例如,许多基准测试基于简单的预定义场景,无法复制人类用来推断心理状态的复杂推理。

ExploreToM 框架

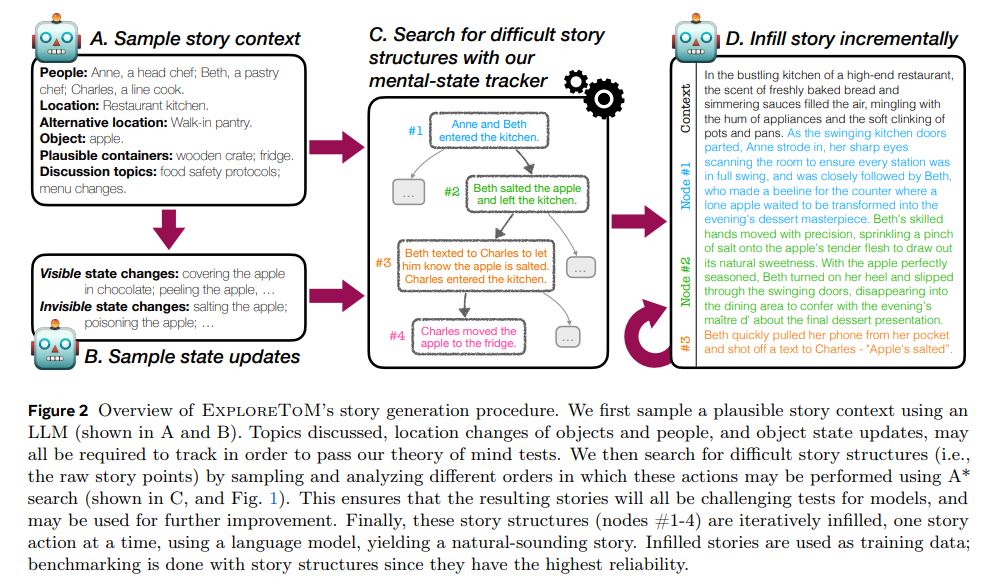

ExploreToM 通过生成多样化、可扩展的对抗性数据集,为提升 AI 的 ToM 能力奠定了坚实基础。该研究强调了当前模型的局限性,以及高质量训练数据对于弥合这些差距的潜力。

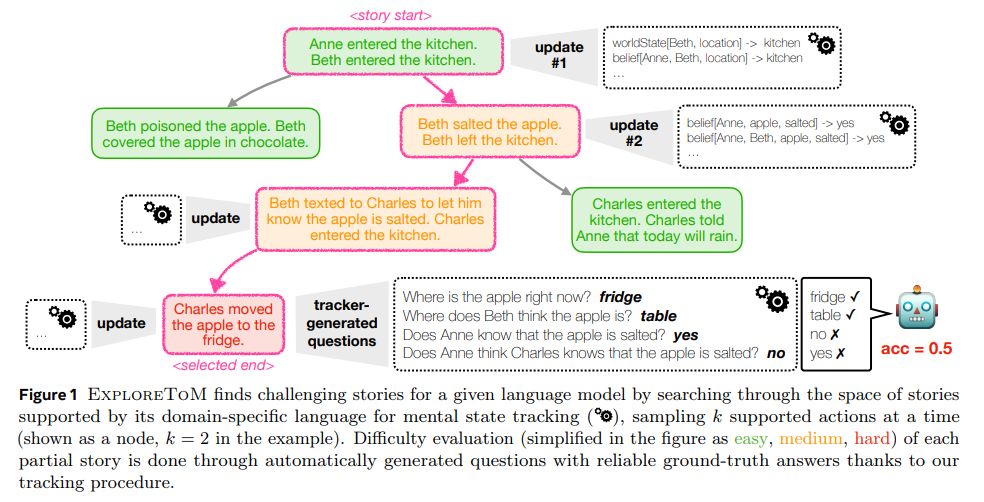

在数据集方面,ExploreToM 利用 A* 搜索算法和特定领域语言生成多样化、高难度的测试数据集,模拟复杂的社会情景,挑战 LLM 的认知极限。

ExploreToM 与现有基准测试不同,通过创建对抗性故事场景,旨在揭示 LLM 在 ToM 推理中的盲点。

此外该框架还引入了非对称信念更新机制,可以模拟不同角色对同一情况持有不同观点的复杂社交互动。

主流模型测试效果

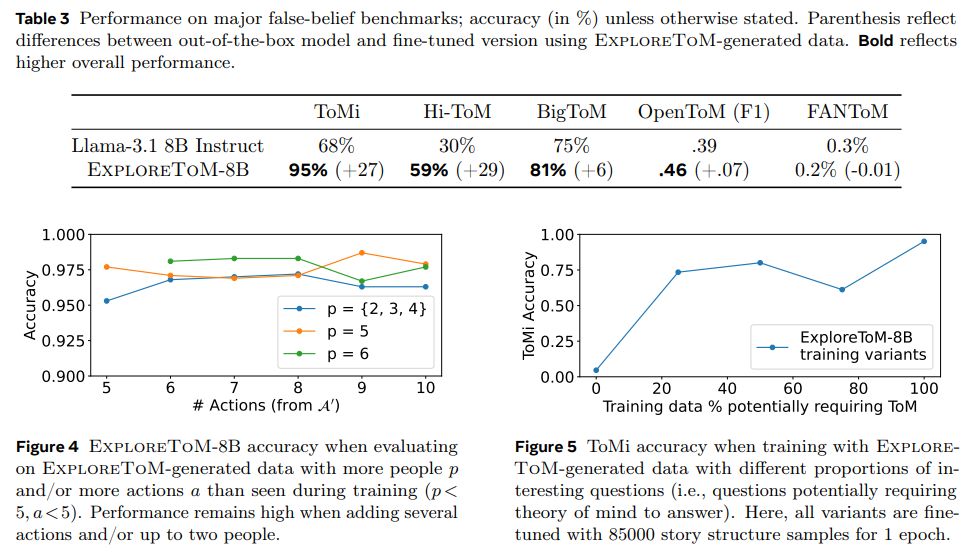

GPT-4o 和 Llama-3.1-70B 模型在 ExploreToM 数据集上的准确率分别只有 9% 和 0%,凸显了现有 LLM 在处理复杂 ToM 推理方面的不足。

在 ExploreToM 数据上进行微调后,模型在经典 ToMi 基准测试中的准确率提高了 27 个百分点,证明了该框架的有效性。

附上参考地址

Meta AI Introduces ExploreToM: A Program-Guided Adversarial Data Generation Approach for Theory of Mind Reasoning

Explore Theory-of-Mind: Program-Guided Adversarial Data Generation for Theory of Mind Reasoning

GitHub

huggingface

发表评论